Investigadores del Salk, junto con otros colaboradores, han realizado grandes avances en la comprensión del tamaño de las conexiones neuronales, incrementando significativamente las estimaciones de la capacidad cerebral. Esta nueva visión también arroja luz sobre la excelente eficiencia energética del cerebro y podría ayudar a ingenieros a construir ordenadores mucho más potentes y que al mismo tiempo conserven la energía.

“Esto es realmente un bombazo en el campo de la neurociencia,” explica Terry Sejnowski, profesor en Salk y coautor principal del artículo de investigación, publicado en eLife. “Hemos descubierto la llave para descifrar las claves del diseño de cómo las neuronas del hipocampo funcionan, usando baja energía pero obteniendo un alto poder computacional. Nuestras nuevas mediciones de la capacidad de memorizar del cerebro aumentan las actuales estimaciones hasta diez veces, llegando al petabyte, similar al Internet.” [¡QFC! se ha limitado a citar las palabras del profesor Sejnowski, si bien no ha podido averiguar de dónde procede esta comparación. A modo de ejemplo, en 2009 se estimó la capacidad de almacenamiento de Internet (www.) en medio zettabyte; el equivalente a un millón petabytes. Esto fue hace 7 años, y hoy en día esta capacidad no se ha reducido a la millonésima parte sino que ha aumentado sustancialmente]

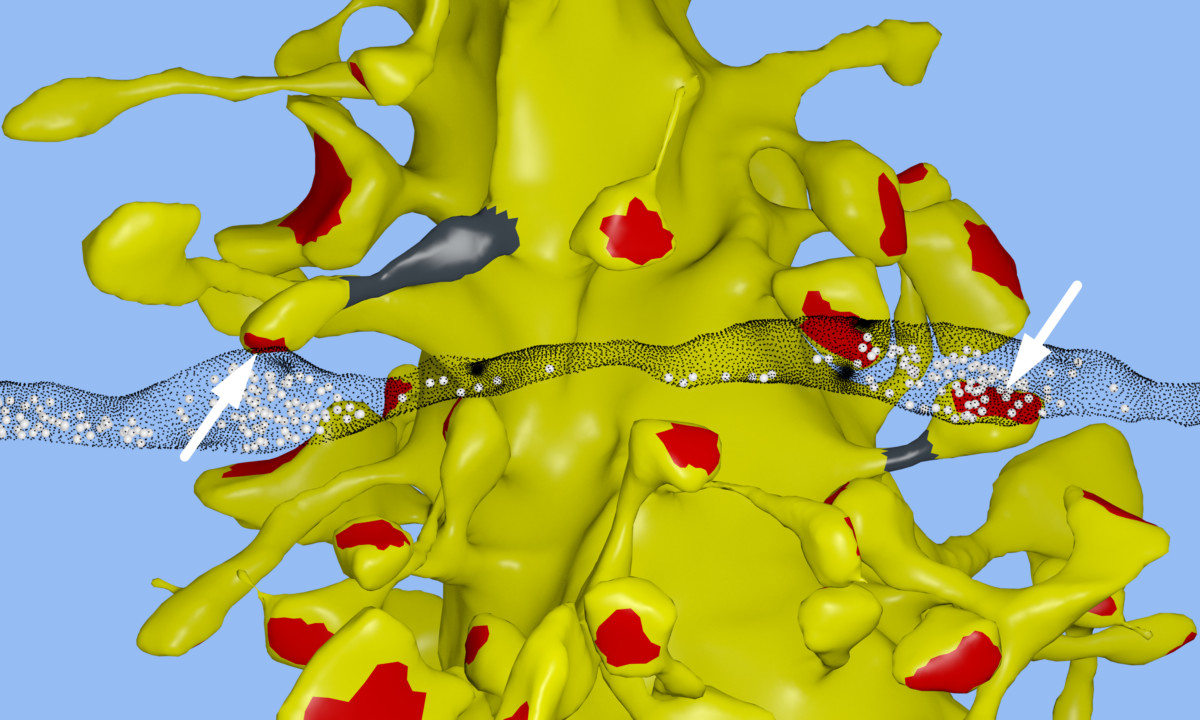

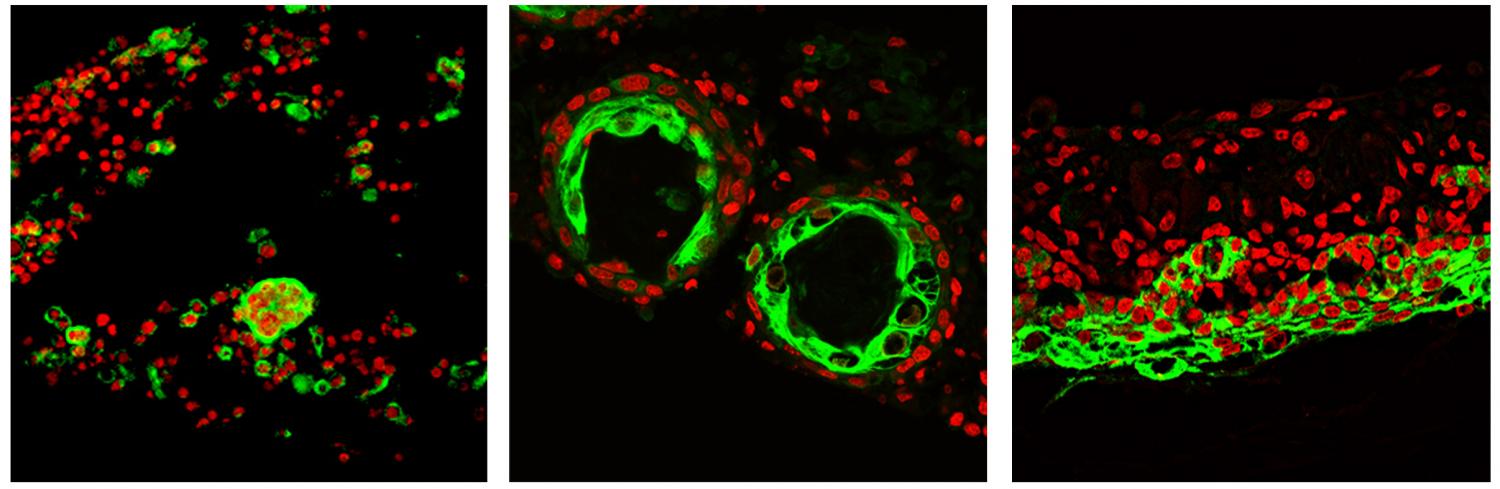

Nuestras memorias y pensamientos son el resultado de patrones de actividad eléctrica y química en el cerebro. Una parte esencial de la actividad sucede en el momento en que ramificaciones neuronales, similares a cables eléctricos, interactúan en ciertas uniones llamadas sinapsis. Un cable de salida (llamado axón) de una neurona se conecta con un cable de entrada (llamado dendrita) de otra. Las señales viajan a través de la sinapsis mediante el uso de componentes químicos llamados neurotransmisores que notifican a la neurona recipiente si debe transmitir este pulso eléctrico al resto de neuronas. Cada neurona puede tener miles de estas sinapsis con miles de otras neuronas.

“En el momento en que reconstruimos cada dendrita, axón, proceso glial [procesos relacionados con células que, además de intervenir activamente en el procesamiento cerebral, sirven de soporte a las neuronas] y sinapsis de un hipocampo, del volumen de un glóbulo rojo, de alguna forma nos quedamos perplejos por la complejidad y diversidad de las sinapsis,” comenta Kristen Harris, coautor principal del trabajo y profesor de neurociencia en la Universidad de Texas, Austin. “Si bien esperaba aprender de estas detalladas reconstrucciones los principios fundamentales sobre cómo el cerebro queda organizado, me ha dejado atónito la precisión en el análisis a la que se ha llegado en este trabajo.”

El equipo del Salk observó algo curioso mientras realizaban una reconstrucción en 3D del hipocampo de una rata. El hipocampo se puede entender como el centro de memoria del cerebro. En algunos casos, un único axón formaba dos sinapsis que se conectaban a su vez a una misma dendrita. Esto significa que la primera neurona parecía estar enviando mensajes duplicados a la segunda.

Al principio, los investigadores no le dieron mayor importancia a esta redundancia, que de hecho ocurre alrededor de un 10% de las veces en el hipocampo. Pero Tom Bartol, un científico perteneciente al equipo, sugirió algo: si pudieran ser capaces de medir la diferencia entre dos sinapsis muy similares como lo eran estas, entonces podrían sacar conclusiones sobre los diferentes tamaños de sinapsis, que hasta entonces se habían clasificado como pequeñas, medianas o grandes.

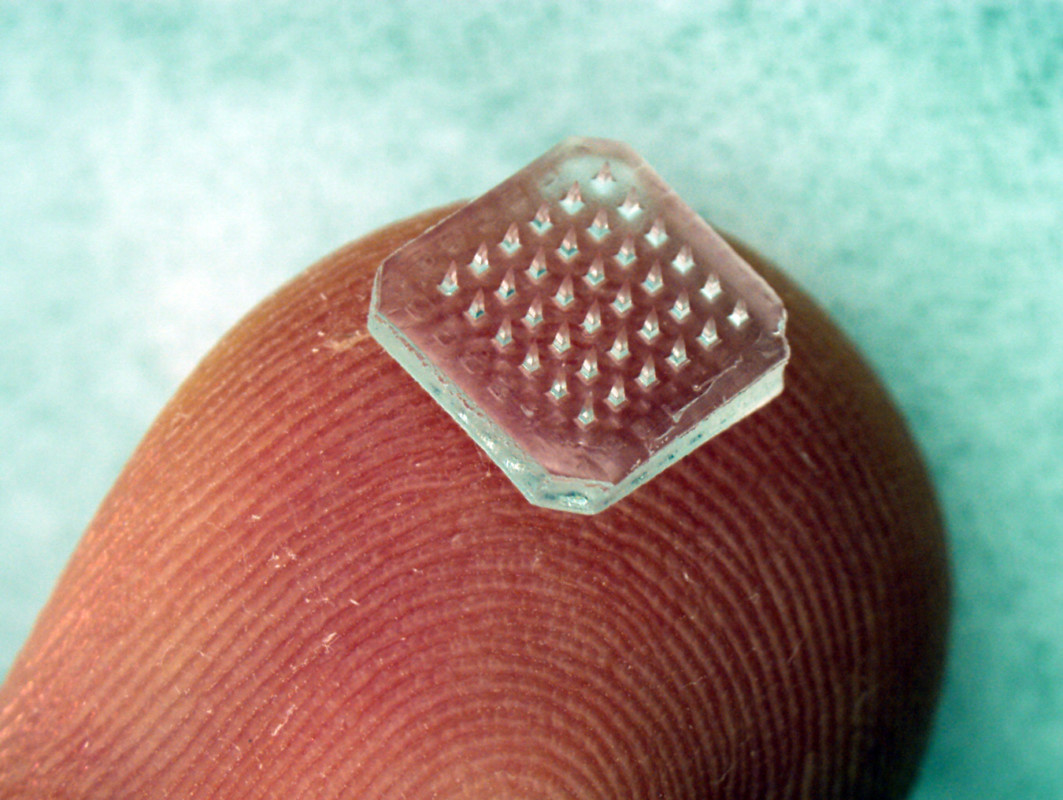

Para ello los científicos utilizaron sofisticados microscopios y algoritmos computacionales avanzados para replicar el cerebro de una rata y reconstruir la conectividad, las formas, los volúmenes y la superficie del tejido cerebral hasta niveles nanomoleculares. “Nos dejó boquiabiertos el ver que la diferencia de tamaños [que se vio era significativa] de cada pareja de sinapsis era en realidad muy pequeña, con diferencias de alrededor de un 8%,” explica Bartol. Esto significa que no sólo existen 3 tipos de sinapsis, sino muchos más.

Ya que la capacidad de memoria de las neuronas es dependiente del tamaño de la sinapsis, este 8% de diferencia básicamente vino a ser un número clave que al incluirlo en su algoritmo permitió a los científicos calcular la información que podría contener cada conexión sináptica. Hasta entonces se creía que existía una variación de factor 60 entre los tamaños de las sinapsis pequeñas y grandes, pero con estos descubrimientos de variaciones menores los tipos de sinapsis resultantes aumentaron a 26.

En términos computacionales, 26 tipos de sinapsis corresponden a unos 4,7 bits de información. Hasta ahora se creía que el cerebro tenía capacidad para almacenar 1 o 2 bits para las memorias a corto y largo plazo en el hipocampo. Este nuevo estudio, por lo tanto, supone un gran avance en el entendimiento del mecanismo del cerebro.

“Las implicaciones de este estudio son muy trascendentales,” explica Sejnowxki. “Escondido bajo el aparente caos y desorden del cerebro existe una subyacente precisión del tamaño y forma de las sinapsis que hasta ahora escapaba a nuestra percepción.”

Estos resultados ofrecen una explicación de la sorprendente eficiencia del cerebro. El cerebro adulto genera alrededor de 20 vatios de potencia (como una bombilla de baja intensidad). Estos descubrimientos podrían ayudar a ingenieros y científicos a construir ordenadores ultraprecisos y eficientes, principalmente para usos de aprendizaje profundo y redes neuronales artificiales, capaces de aprender y analizar, por ejemplo, el habla e identificar objetos.