Con las Tres Leyes de la Robótica, el autor de ciencia ficción Isaac Asimov estaba pensando en androides. Imaginó un mundo en el que estos robots humanos actuarían como siervos y necesitarían un conjunto de reglas de programación para evitar que causaran daño. Pero en los 75 años transcurridos desde la publicación de la primera historia para presentar sus directrices éticas, ha habido avances tecnológicos significativos. Ahora tenemos una concepción muy diferente del aspecto de los robots y de nuestra interactuación con ellos.

El campo, altamente evolucionado, de la robótica está produciendo una enorme gama de dispositivos, desde aspiradores autónomos hasta aviones militares, hasta líneas de producción completas en las fábricas. Al mismo tiempo, la inteligencia artificial y el aprendizaje automático están, cada vez más, detrás de gran parte del software que nos afecta a diario, ya sea en las búsquedas en Internet o en la asignación de servicios gubernamentales. Estos acontecimientos nos están llevando rápidamente a una era en que robots de todas las clases llegarán a prevalecer en casi todos los aspectos de la sociedad, y las interacciones entre humanos y robots aumentarán perceptiblemente.

Las leyes de Asimov todavía se mencionan como una plantilla para guiar nuestro desarrollo de los robots. El gobierno de Corea del Sur incluso propuso una carta de ética robótica en 2007 que refleja las leyes. Pero dado lo mucho que ha cambiado la robótica y lo que seguirá creciendo en el futuro, necesitamos preguntarnos cómo podrían actualizarse estas reglas para una versión del siglo XXI de la inteligencia artificial.

Las Tres Leyes de la robótica de Asimov

Las leyes sugeridas por Asimov fueron ideadas para proteger a los humanos de las interacciones con los robots. Son:

- Un robot no hará daño a un ser humano o, por inacción, permitir que un ser humano sufra daño.

- Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la 1ª Ley.

- Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la 1ª o la 2ª Ley.

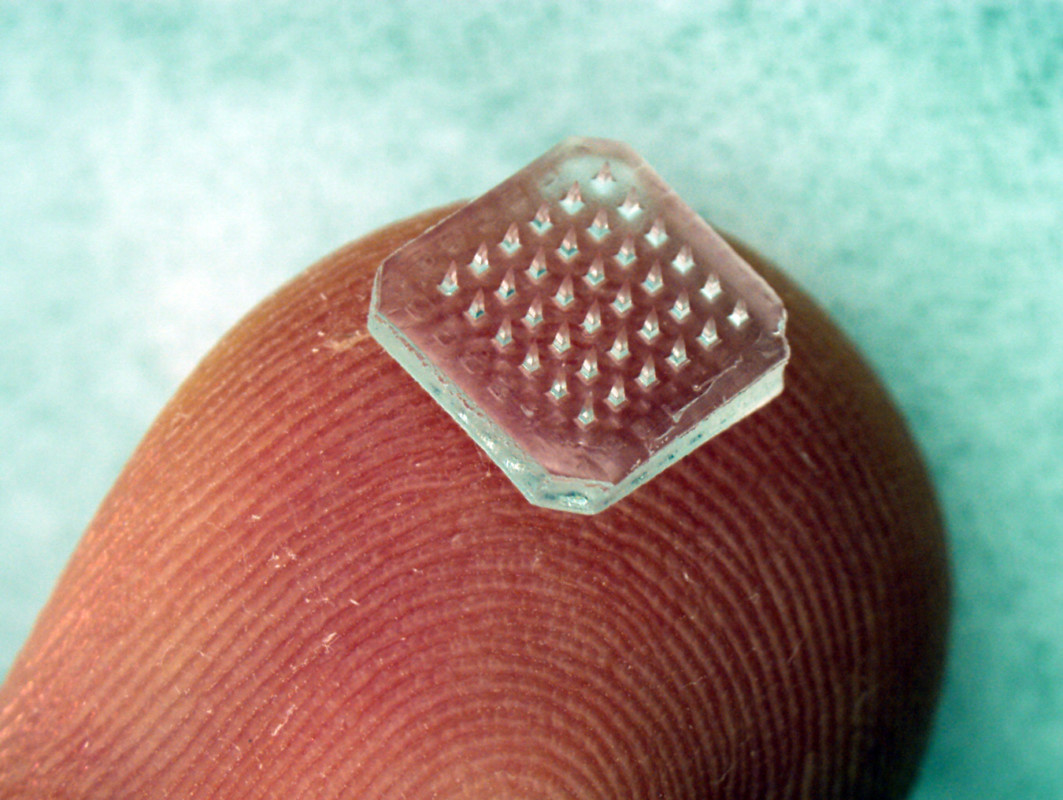

Como se ha mencionado, uno de los problemas obvios es que los robots hoy parecen ser mucho más variados que los de las historias de Asimov, incluyendo algunos que son mucho más simples. Por lo tanto, debemos considerar si debemos tener un umbral de complejidad por debajo del cual las reglas no sean necesarias. Es difícil concebir una aspiradora robótica que tenga la capacidad de dañar a seres humanos o incluso de requerir una capacidad de obedecer órdenes. Es un robot con una sola tarea que puede ser predeterminada antes de ser encendido. [Otros ejemplos que hemos visto en ¡QFC! son los robots de fábrica, robots monotarea como este que asiste en el latido del corazón, o los digeribles.]

En el otro extremo del espectro, sin embargo, están los robots diseñados para entornos de combate militar. Estos dispositivos están diseñados para el espionaje, la eliminación de bombas o el transporte de carga. En un principio estos aún parecen alinearse con las leyes de Asimov, particularmente porque están siendo creados para reducir el riesgo de pérdidas de vidas humanas dentro de ambientes altamente peligrosos.

Pero es sólo un pequeño paso para asumir que el objetivo militar final sería crear robots armados que podrían ser desplegados en el campo de batalla. En esta situación, la Primera Ley (no dañar a los seres humanos) se vuelve enormemente problemática. El papel de los militares a menudo es salvar las vidas de soldados y civiles, pero a menudo dañando a sus enemigos en el campo de batalla. Así que puede ser necesario reconsiderar las leyes desde diferentes perspectivas o interpretaciones.

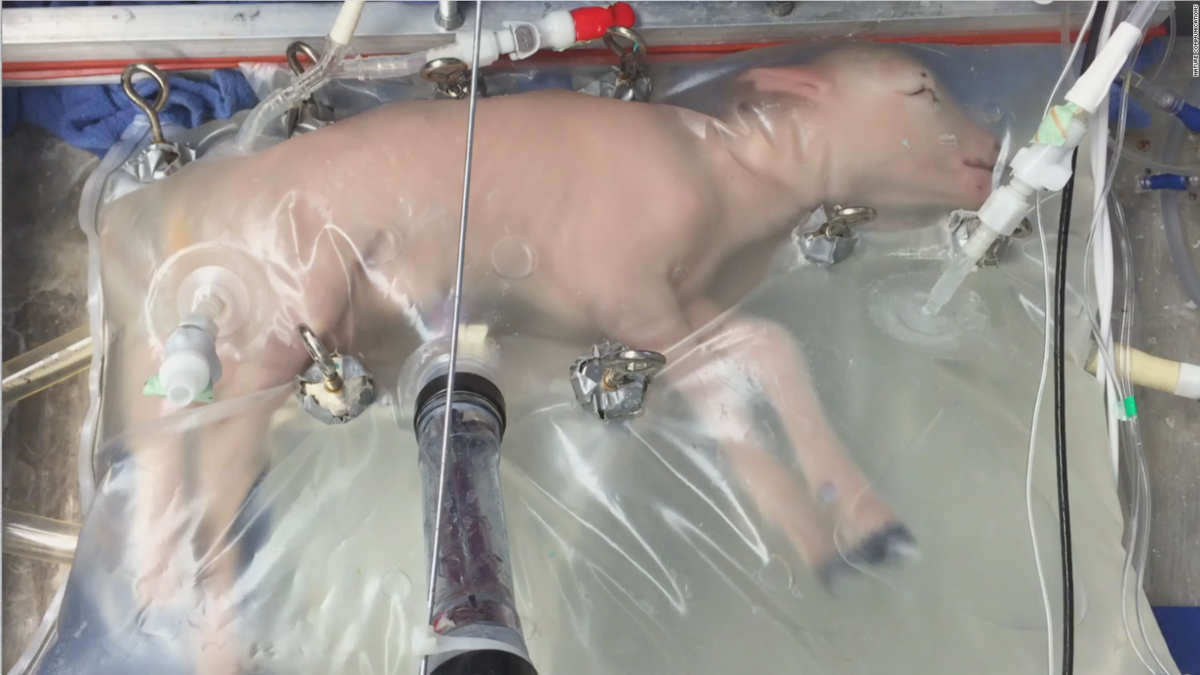

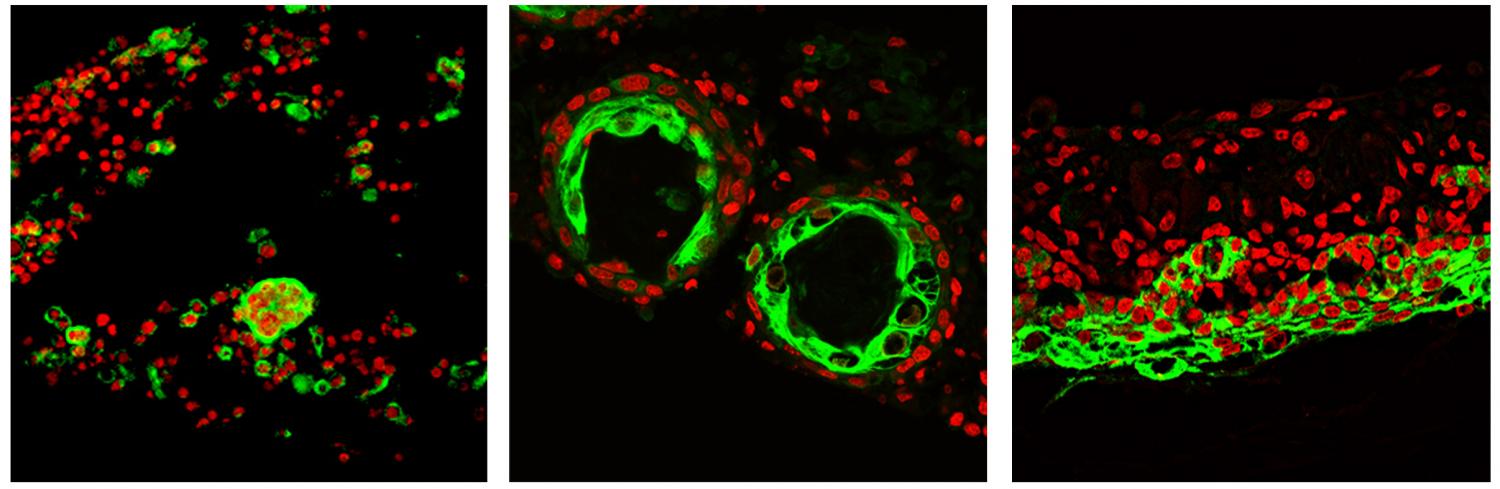

La ambigüedad de las leyes ha llevado a los autores, incluyendo a Asimov, a explorar cómo podrían ser mal interpretadas o aplicadas incorrectamente. Un problema es que en realidad no definen lo que es un robot. Conforme la investigación empuja los límites de la tecnología, existen ramas emergentes de la robótica que miran a dispositivos moleculares.

Por ejemplo, «robots» hechos de ADN y proteínas podrían ser usados en cirugía para corregir desórdenes génicos. En teoría, estos dispositivos deberían seguir las leyes de Asimov. Pero para que siguieran órdenes a través de señales de ADN, tendrían que convertirse esencialmente en una parte integral del ser humano en el que estaban trabajando. Esta integración haría entonces difícil determinar si el robot es lo suficientemente independiente como para caer bajo las leyes u operar fuera de ellas. Y a nivel práctico sería imposible para él determinar si cualquier orden recibida causaría daño al ser humano si se lleva a cabo.

También está la cuestión de lo que cuenta como dañar a un ser humano. Esto podría ser un problema al considerar el desarrollo de bebés robot en Japón, por ejemplo. Si un humano adoptara uno de estos robots, podría causar daño emocional o psicológico. Pero este daño puede no haber ocurrido a partir de las acciones directas del robot o ser aparente hasta muchos años después de que la interacción humano-robot haya terminado. Este problema podría aplicarse incluso a una IA mucho más simple, como el uso del aprendizaje automático para crear música que provoque emociones.

Problemas prácticos

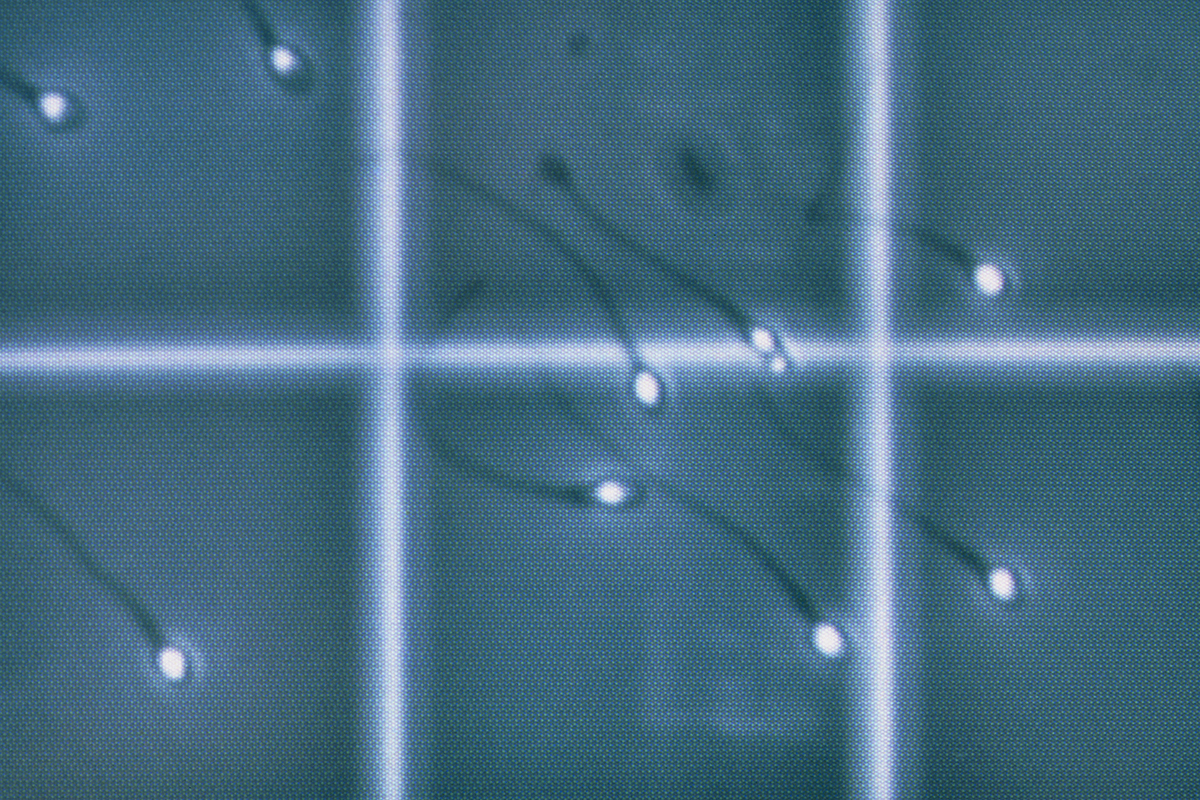

El otro gran problema con las leyes es que necesitamos un avance significativo en la inteligencia artificial para que los robots realmente puedan seguirlas. El objetivo de la investigación de la IA se describe a veces como el desarrollo de máquinas que pueden pensar y actuar racionalmente y como un ser humano. Hasta ahora, la emulación del comportamiento humano no ha sido bien investigada en el campo de la IA y el desarrollo del comportamiento racional se ha centrado en áreas limitadas y bien definidas.

Teniendo esto en cuenta, un robot sólo podría operar dentro de una esfera muy limitada y cualquier aplicación racional de las leyes sería altamente restringida. Podría incluso no ser posible con la tecnología actual, ya que un sistema que pudiera razonar y tomar decisiones basadas en las leyes necesitaría un poder computacional considerable.

Dadas todas estas trabas, las leyes de Asimov suponen poco más que principios fundacionales para alguien que quiera crear un código robótico hoy. Necesitamos seguirlas con un conjunto mucho más amplio de leyes [como el propuesto por expertos, que explicamos en esta historia]. Dicho esto, sin desarrollos significativos en IA, la implementación de tales leyes seguirá siendo una tarea imposible. Y esto es previo incluso a considerar el daño potencial que podría causar si los seres humanos empiezan a enamorarse de los robots.

Artículo original publicado por The Conversation. Revisado y traducido por ¡QFC!